在深入研究 AI 和加密貨幣結合的領域數月後,對這個方向的理解更加深入。 本文對早期觀點和目前的賽道走向進行了對比分析

作者:Ian@Foresight Ventures

封面:Photo by Jigar Panchal on Unsplash

TL; DR

在深入研究 AI 和加密貨幣結合的領域數月後,對這個方向的理解更加深入。 本文對早期觀點和目前的賽道走向進行了對比分析,對賽道熟悉的朋友可以從第二個 section 開始看。

- 去中心化算力網路:面臨市場需求挑戰,特彆強調去中心化的終極目的是降低成本。 Web3 的社區屬性和 token 帶來了不可忽視的價值,但對於算力賽道本身來說還是一種附加值,而非顛覆性的改變,重點在於找到與使用者需求結合的方式,而不是盲目將去中心化算力網路作為一種對於中心化算力不足的補充。

- AI 市場:討論了一個全鏈路金融化的 AI 市場的構想,社區和代幣帶來的價值和至關重要。 這樣的市場不僅關注底層算力和數據,還包括模型本身和相關應用。 模型金融化是 AI 市場的核心要素,一方面吸引使用者直接參與到 AI 模型的價值創造過程,另一方面給底層的算力和數據創造需求。

- Onchain AI,ZKML 面臨需求和供給的雙重挑戰,而 OPML 則提供了一種成本和效率更為平衡的方案。 儘管 OPML 在技術上是一個創新,但它未必能解決鏈上 AI 面臨的根本性挑戰,即沒有需求。

- 應用層,大部分 web3 的 AI 的應用專案都過於 naive,AI 應用更合理的點在於增強用戶體驗和提高開發效率,或是作為 AI 市場中的重要一環。

一、AI 賽道回顧

在過去幾個月我對 AI + crypto 這個話題進行了深度的研究,經過幾個月的沉澱,很高興自己在比較早的階段洞悉到了一些賽道的走向,但也能看到有一些現在看來並不準確的觀點。

這篇文章只講觀點不做 intro,會覆蓋 web3 里 AI 的幾個大方向並且展示之前和現在我對賽道的觀點和分析。 不同的視角可能會有不一樣的啟發,可以對比辯證地來看。

先來回顧一下在上半年定下的 AI + crypto 幾個主要的方向:

1.1 分散式算力

在「理性看待去中心化算力網路」中,基於算力將成為未來最有價值的資源的大邏輯,分析了 crypto 能為算力網路賦予的價值。

雖然去中心化的分散式算力網路在 AI 大模型訓練上的需求是最大的,但是也面臨最大的挑戰和技術瓶頸。 包括需要複雜的數據同步和網路優化問題等。 此外,數據隱私和安全也是重要的制約因素。 雖然有一些現有的,技術能提供初步解決方案,但在大規模分散式訓練任務中,由於計算和通信開銷巨大,這些技術仍無法應用。 顯然去中心化的分散式算力網路在模型推理上更有機會落地,可以預測未來的增量空間也足夠大。 但也面臨通信延遲、數據隱私、模型安全等挑戰。 和模型訓練相比,推理時的計算複雜度和數據交互性較低,更適合在分散式環境中進行。

1.2 去中心化 AI 市場

在「去中心化 AI Marketplace 的最佳嘗試」中,提到了一個成功的去中心化 AI marketplace 需要將 AI 和 Web3 的優勢緊密結合,利用分散式、資產確權、收益分配和去中心化算力的附加值,降低 AI 應用的門檻,鼓勵開發者上傳和分享模型,同時保護用戶的數據私有權,構建一個開發者友好,且滿足使用者需求的 AI 資源交易、共享平臺。

當時的想法是(現在看來可能也不完全準確)基於數據的 AI marketplace 有更大的潛力。 死磕模型的 marketplace 需要大量高品質模型的支撐,但早期平臺缺乏用戶基數和優質資源,使得優秀模型提供者的激勵不足,難以吸引優質模型; 而基於數據的 marketplace 通過去中心化,分散式地採集、激勵層設計和數據擁有權的保證,可以積累大量有價值的數據和資源,尤其是私域數據。

去中心化 AI marketplace 的成功依賴於使用者資源的累積和強大的網路效應,用戶和開發者可以從市場中獲得的價值超過他們在市場之外能夠得到的價值。 在市場的早期,重點在於積累優質模型以吸引並保留使用者,然後在建立起優質模型庫和數據壁壘后,轉向吸引和留住更多的終端使用者。

1.3 ZKML

在 ZKML 的話題被廣泛討論之前就在「AI + Web3 = ? 中對鏈上 AI 的價值進行了討論。

在不犧牲去中心化和 trustless 的基礎上,onchain AI 有機會帶領 web3 世界進入 “next level”。 目前的 web3 就像是 web2 的早期階段,還沒有承接更廣泛應用或者創造更大價值的能力。 而 onchain AI 恰好為了提供一種透明的、trustless 的解決方案。

1.4 AI 應用

在「AI+ Crypto 出發聊聊 Web3 女性向遊戲—HIM」中,結合 portfolio 專案「HIM」解析了大模型在 web3 應用上帶來的價值; 什麼樣的 AI + crypto 能給產品帶來更高回報? 除了硬核地從基建到演算法,開發鏈上 trustless 的 LLM,另一個方向是在產品中淡化推理的過程黑盒帶來的影響,找到契合的場景來將大模型強大的推理能力落地。

二、當下的 AI 賽道分析

2.1 算力網路:想像空間很大但門檻高

算力網路的大邏輯依然沒變,但是仍然面臨市場需求的挑戰,誰會需要效率和穩定性更低的解決方案? 因此,以下這幾點我認為需要想通:

去中心化是為了什麼?

要是現在去問一個去中心化算力網路的 founder,他八成還是會告訴你我們的算力網路可以增強的安全性和抗攻擊能力、提高透明度和信任、資源優化利用、更好的數據隱私和使用者控制、抵禦審查和干預......

這些都是 common sense,任何 web3 專案都能扯到抗審查、去信任、隱私等等,但我的觀點是這些都不重要。 仔細想一下,論安全性難道中心化的伺服器不能做的更好? 去中心化的算力網路本質上也沒有解決隱私的問題,諸如此類的矛盾點還有很多。 所以:一個算力網路去中心化終極目的一定是為了更低的成本。 去中心化的程度越高,使用算力的成本越低。

所以,從根本上看「利用閑置算力」更多是一種長遠的敘事,而一個去中心化算力網路能不能做成,我認為很大程度上取決於他有沒有想明白以下幾點:

Web3 提供的價值

一套巧妙的 token 設計以及隨之而來的激勵/懲罰機制顯然是去中心化社區提供的強有力 value add。 相比傳統互聯網,token 不僅作為交易媒介,和 smart contract 相輔相成能讓 protocol 實現更複雜的激勵和治理機制。 同時,交易的公開透明、成本的降低、效率的提升都得益於 crypto 帶來的價值。 這種獨特的價值為激勵貢獻者提供了更多靈活性和創新空間。

但同時也希望可以理性看待這種看似合理的「契合」,對於去中心化算力網路來說,Web3 和區塊鏈技術帶來的這些價值從另一個角度看僅僅只是「附加值」,而不是根本性的顛覆,並不能改變整個網路的基本工作方式和突破現在的技術瓶頸。

簡而言之,這些 web3 的價值在於增強了去中心化網路的吸引力,但不會完全改變其核心結構或運作模式,如果希望去中心化網路在 AI 浪潮裡真正佔據一席之地,僅僅靠 web3 的價值是遠遠不夠的。 因此,就像後面會提到的,合適的技術解決合適的問題,去中心化算力網路的玩法絕不是單純地去解決 AI 算力短缺的問題,而是給這個沉寂已久的賽道一個新的玩法和思路。

可能是像 pow 挖礦或者存儲挖礦一樣,把算力作為一種資產進行貨幣化。 在這種模式下,算力的提供者可以通過貢獻自己的計算資源來獲取代幣作為報酬。 吸引力在於它提供了一種直接將計算資源轉換為經濟收益的方式,從而激勵更多的參與者加入網路。 也可能是基於 web3 創造一個消耗算力的市場,通過將算力的上游金融化(比如模型),開闢出能接受不穩定、且更慢的算力的需求點。

想明白怎麼和用戶的實際需求結合,畢竟用戶和參與者的需求不一定只是高效的算力,“能賺到錢” 永遠是最有說服力的動力之一。

去中心化算力網路的核心競爭力是價格

如果一定要從實際價值上討論去中心化算力,那 web3 帶來最大的想像空間就是有機會被進一步壓縮的算力成本。

算力節點的去中心化程度越高,單位算力的價格越低。 從以下幾個方向可以推演:

- token 的引入,支付給節點算力提供者的從現金變為協定的原生代幣,這從根本上降低了運營成本;

- 在准入上的 permissionless 以及 web3 強大的社區效應直接促成了一種市場驅動的成本優化,更多個人使用者和小型企業可以利用現有的硬體資源加入網路,算力供應增加,市場上算力的供應價格下降。 在自治和社區管理模式下。

- 協定所創造的開放的算力市場會促進算力提供者的價格博弈,從而進一步降低成本。

Case: ChainML

簡單來說:ChainML 是一個為 inference、finetuning 提供算力的去中心化平臺。 從短期看,chainml 會實現基於開源的 AI 代理框架 Council,通過 Council 的嘗試(一個 chatbot,可以 integrate 到不同 application 中)為去中心化計算網路帶來需求的增長。 從長期看,chainml 會是一個完整的 AI + web3 平臺(後面會詳細分析),其中就包括模型市場和算力市場。

我認為 ChainML 的技術路徑規劃非常合理,之前提到的問題他們想的也很明白,去中心化算力的目的一定不是和中心化的算力相提並論,給 AI industry 提供充足的算力 supply,而是逐步降低成本讓合適的需求方接受這種品質更低的算力來源。 那麼,在專案初期,在協定無法獲取大量去中心化算力節點的情況下,重點就是找到一個穩定且高效的算力來源,因此,從產品路徑看,應當是先從中心化的方式做起,在早期階段就把產品鏈路跑通,並且通過強大的 bd 能力開始積累客戶,拓展和據市場,然後逐步將中心化算力的提供者分散到更成本的小公司,最後把算力節點大範圍地鋪開。 這就是 chainml divide and conquer 的思路。

從需求端的佈局看,ChainML 構建了一個中心化的基礎設施協定的 MVP,設計理念是可移植的。 並且從今年 2 月開始就在和客戶一起運行這個系統,在今年 4 月開始在生產環境中使用。 目前正 Google Cloud 上運行,但基於 Kubernetes 和其他開源技術,很容易移植到其他環境(AWS、Azure、Coreweave 等)。 後續會逐步去中心化這個協定,分散到小眾雲,然後最後是提供算力的礦工。

2.2 AI 市場:想像空間更大

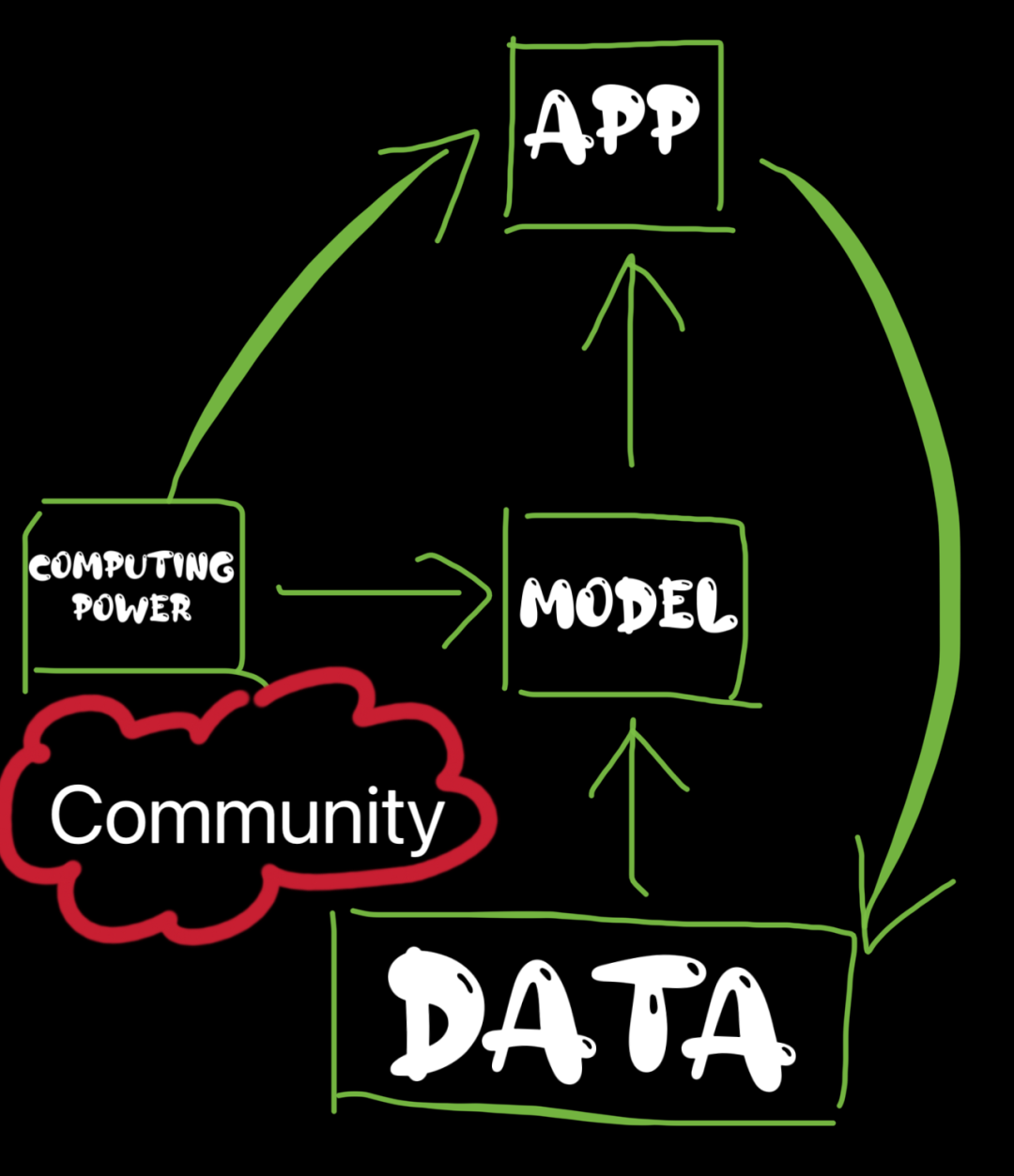

這個 sector 叫 AI markerplace 多少有點限制了想像空間。 嚴格意義上來說,一個真正具備想像空間的 “AI 市場” 應該是一種將模型全鏈路金融化的中間平臺,涵蓋從底層的算力和數據,到模型本身和相關的應用。 之前提到去中心化算力在早期的主要矛盾是如何創造需求,而一個閉環的將 AI 全鏈路金融化的市場正好有機會誕生出這類需求。

大概是這樣:

一個 web3 加持下的 AI 市場以算力和數據為底層,吸引開發者通過更有價值的數據搭建或者微調模型,進而發展出相應的基於模型的應用,這些應用和模型在開發和使用的同時也為算力創造了需求。 在代幣和社區的激勵下,基於 bounty 的實時數據採集任務或者常態化的對於貢獻數據的激勵都有機會擴充並且擴大該市場中數據層的獨特優勢。 同時,應用的普及也返回給數據層更多有價值的數據。

社區

除了之前提到的 token 帶來的價值,社區無疑是 web3 帶來的最大增益之一,是推動平台發展的核心動力。 社區和 token 的加持使得貢獻者和貢獻內容的質量有機會超過中心化機構,比如,數據多樣性成就是這類平臺的一個優勢,這對於構建準確、無偏見的 AI 模型是至關重要的,同時也是目前數據方向的瓶頸所在。

整個平臺的核心我認為就在於模型,我們在很早的時候就意識到,一個 AI marketplace 是否成功取決於是否存在高品質的模型,以及開發者有什麼動力來一個去中心化的平臺提供模型? 但我們似乎也忘記思考了一個問題,拼基建不如傳統平臺硬,拼開發者社區不如傳統平臺成熟,拼聲譽也沒有傳統平臺的先發優勢,那麼相比傳統 AI 平臺龐大的使用者基數和成熟的基建,web3 的專案只能彎道超車。

答案可能就在 AI 模型金融化

- 模型可以被當作為一種商品,將 AI 模型視為可投資的資產是可能是 Web3 和去中心化市場的一個有意思的創新。 這種市場允許使用者直接參與到 AI 模型的價值創造過程中,並從中受益。 這種機制也鼓勵了對更高品質模型的追求和社區的貢獻,因為使用者的收益直接與模型的性能和應用效果相關聯;

- 用戶可以通過對模型進行質押來投資,引入收益分成的機制一方面激勵使用者選擇和支援有潛力的模型,為模型開發者創造更優秀的模型提供了經濟激勵。 另一方面,對於質押者來說最直觀的評判模型的標準(特別是對於圖像生成類的模型)就是多次進行實測,那麼這就為平臺的去中心化算力提供了需求,這可能也是之前提到的 “誰會想用更低效更不穩定的算力?” 的出路之一。

2.3 Onchain AI:OPML 彎道超車?

ZKML:需求和供給兩端雙雙踩雷

可以肯定的是 on-chain AI 一定是一個充滿想像空間,並且值得深入研究的方向。 鏈上 AI 的突破能為 web3 帶來前所未有的價值。 但同時,ZKML 極高的學術門檻和對底層基建的要求確實不適合大多數初創公司死磕。 大多數專案也不一定需要融入 trustless LLM 的支援才能達成自身價值的突破。

但並不是所有 AI 模型都需要搬到鏈上用 ZK 來做 trustless,就像大多數人並不關心 chatbot 是怎麼對 query 進行推理並給出結果的,也不在意使用的 stable diffusion 是否是某個版本的模型架構或者特定的參數設置。 在大多數場景中,大多數用戶關注的是模型是否能給一個滿意的 output,而不是推理的過程是否 trustless 或者透明。

如果 proving system 並沒有帶來百倍的 overhead 或者更高的推理成本,或許 ZKML 還有一戰之力,但在高昂的鏈上推理成本和更高的成本面前,任何需求方都有理由質疑 Onchain AI 的必要性。

從需求端看

使用者在乎的是模型給出的結果是不是 make sense,只要結果合理,ZKML 帶來的 trustless 可以說一文不值; 試想一下其中一個場景:

- 如果一個基於神經網路的交易機器人每個週期都給用戶帶來百倍的收益,誰還會去質疑演算法是否中心化或者是否可驗證?

- 同樣的,如果這個 trading bot 開始給使用者虧錢了,那專案方更應該思考的是如何提升模型的能力而不是把精力和資本花在讓模型可驗證上。 這就是 ZKML 需求中的矛盾所在,換句話說模型的可驗證在很多場景下並不從根本上解決人們對 AI 的質疑,就有點南轅北轍的意思。

從供給端看

開發足以支撐大預言模型的 proving system 任重而道遠,從現在頭部項目的嘗試看,幾乎看不到大模型上鏈的一天。

參考我們之前關於 ZKML 的文章,從技術上看 ZKML 的目標是將神經網路轉化成 ZK 電路,難點在於:

- ZK 電路不支援浮點數;

- 大規模的神經網路難以轉換。

從當前進展看:

- 最新的 ZKML 庫支援一些簡單的神經網路 ZK 化,據稱能將基礎的線性回歸模型上鏈。 但現存的 demo 很少。

- 理論上最大能支援~100M 的參數,但僅存於理論。

ZKML 的發展進度並沒有達到預期,從目前賽道頭部專案 modulus lab 和 EZKL 發佈的 proving system 的進度看,都能將一些簡單的模型轉化成 ZK 電路做模型的上鏈或推理證明上鏈了。 但這還遠遠沒有達到 ZKML 的價值所在 not event close,並且技術的瓶頸似乎也沒有核心的動力去突破,一個嚴重缺乏需求的賽道從根本上無法獲得學術界的關注,也就意味著更難以做出優秀的 poc 來吸引/滿足僅存的需求而這可能也是殺死 ZKML 的死亡螺旋。

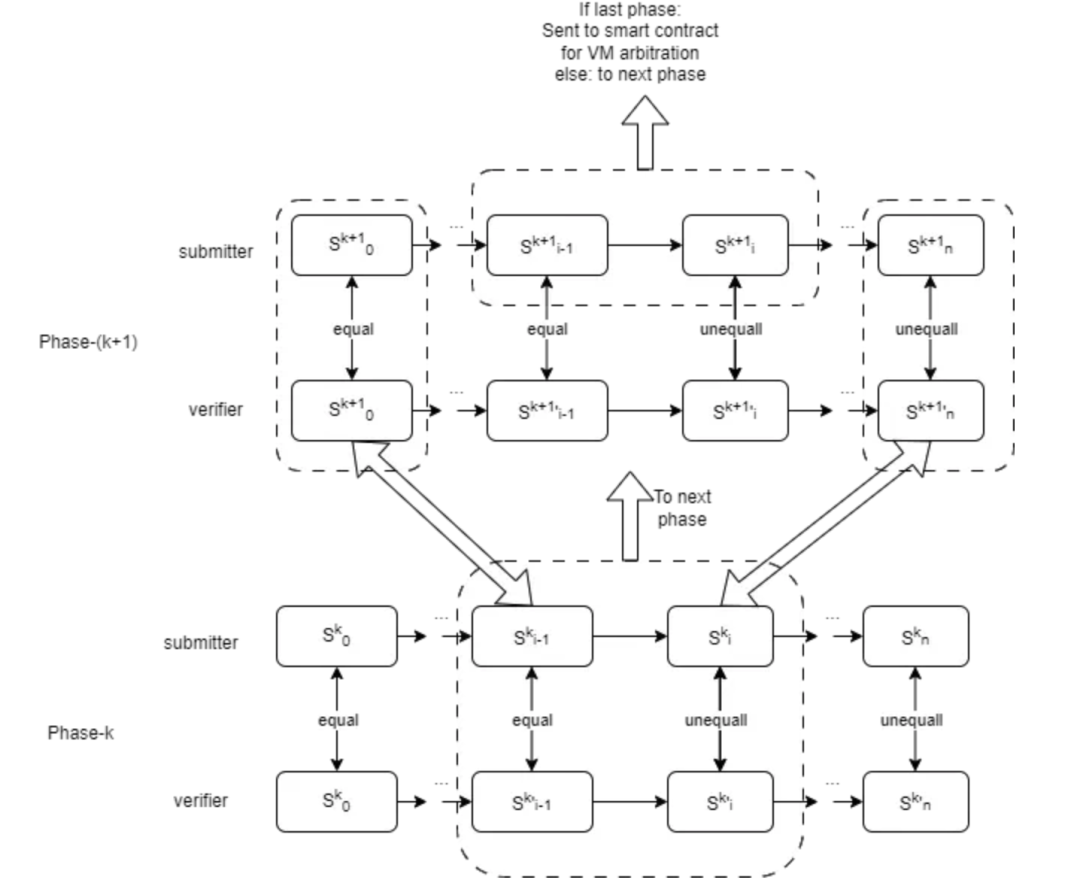

OPML:是過渡還是終局?

OPML 和 ZKML 的差異在於 ZKML 證明瞭完整的推理過程,而 OPML 會在推理受到挑戰時重新執行部分推理過程。 很顯然,OPML 解決的最大的問題就是成本/overhead 過高,這是一種非常務實的優化。

作為 OPML 的開創者,HyperOracle 團隊在 “opML is All You Need: Run a 13B ML Model in Ethereum” 中給出了 one-phase 到 multi-phase opML 的架構和進階過程:

- 構建一個用於鏈下執行和鏈上驗證的虛擬機,確保離線 VM 和鏈上智慧合約中實現的 VM 之間的等效性。

- 為了確保 AI 模型在 VM 中的推理效率,實現一個專門設計的羽量級 DNN 庫(不依賴於像 Tensorflow 或 PyTorch 這樣的流行機器學習框架),同時團隊也提供了一個可以將 Tensorflow 和 PyTorch 模型轉換為這個羽量級庫的腳本。

- 通過交叉編譯將 AI 模型推理代碼編譯成 VM 程式指令。

- VM image 通過 Merkle tree 來管理。 只有代表 VM 狀態的 Merkle root 會被上傳到鏈上智能合約。

但顯然這樣的設計有一個關鍵缺陷,就是所有計算必須在虛擬機內執行,這阻止就阻礙了利用 GPU/TPU 加速以及並行處理,局限了效率。 因此引入 multi-phase opML。

- 只有在 final phase 中,計算在 VM 進行。

- 在其他階段,狀態轉換的計算發生在 native 的環境中,這樣就利用了比如 CPU、GPU、TPU 的能力,並支援並行處理。 這樣的做法減少了對 VM 的依賴,顯著提高了執行性能,達到與原生環境相當的水準。

Reference: https://mirror.xyz/hyperoracleblog.eth/Z__Ui5I9gFOy7-da_jI1lgEqtnzSIKcwuBIrk-6YM0Y

LET’S BE REAL

有觀點認為 OPML 是一種實現全面 ZKML 前的一個過渡,但更現實的說不如把它當作一種 Onchain AI 基於成本結構和落地預期的取捨,或許 ZKML 全面實現的一天永遠不會到來,至少我對此持悲觀的態度,那麼 Onchain AI 的 hype 最終還是要面對最現實的落地和成本,那麼 OPML 可能就是 Onchain AI 的最佳實踐,就像是 OP 和 ZK 的生態也從來不是替代的關係。

雖然但是,不要忘記了,之前需求的短板仍然存在,OPML 基於成本和效率的優化並不從根本上解決「既然使用者更在意結果的合理性,為什麼要把 AI 搬到鏈上做成 trustless」南轅北轍的問題,透明、擁有權、去信任,這些 buff 疊加在一起確實很花裡胡哨,但使用者真的在乎嗎? 相比之下,價值的體現應該是在模型的推理能力上。

我認為這種對成本的優化從技術上是一個創新且 solid 的嘗試,但從價值上看更像是一種蹩腳的圓場;

或許 Onchain AI 這個賽道本身就是在拿著鎚子找釘子,但這也沒錯,一個早期行業的發展就是需要不斷探索跨領域技術的創新結合,在不斷磨合中找到最佳的契合點,錯的從來都不是技術的碰撞和嘗試,而是缺乏獨立思考的盲目跟風。

2.4 應用層:99% 的縫合怪

不得不說 AI 在 web3 應用層的嘗試確實前赴後繼,好像大家都在 fomo,但其中 99% 的 integration 還是就停留在 integration 吧,沒必要藉著 gpt 的推理能力映射專案本身有多大價值。

從應用層看,大致有兩種出路:

- 借助 AI 的能力提升用戶體驗,提升開發效率:這種情況下 AI 並不會是核心亮點,更多時候是作為一種幕後工作者默默付出,甚至對使用者無感; 舉個例子,web3 遊戲 HIM 的團隊對於遊戲內容、AI、crypto 的結合想很聰明,抓住了契合度高,最能產生價值的點,就是一方面利用 AI 作為生產價值工具,提升開效率和品質,另一方面通過 AI 的推理能力提升使用者的遊戲體驗,AI 和 crypto 確實帶來了非常重要的價值,但根本上還是利用了將技術工具化的手段, 專案真正的優勢和核心仍然是團隊對遊戲開發的能力

- 和 AI marketplace 結合,成為整個生態中面向使用者的重要一環。

三、最後...

如果真的有什麼需要強調或者總結的:AI 仍然是 web3 最值得關注也是機會最大的賽道之一,這個大邏輯一定不會變;

但我認為最值得關注的是 AI marketplace 的玩法,從根本上看這種平臺或者 infra 的設計是符合價值創造的需求以及滿足各方利益的,宏觀來說,在模型或者算力本身以外創造出了一種 web3 特有的價值捕獲的方式就足夠有吸引力,同時,這也允許使用者用一種獨特的方式直接參與到 AI 的浪潮中。

或許再過三個月我又會推翻我現在的想法,所以:

以上只是我關於這個賽道很 real 的觀點,真的不構成任何投資建議!

Reference

“opML is All You Need: Run a 13B ML Model in Ethereum”: https://mirror.xyz/hyperoracleblog.eth/Z__Ui5I9gFOy7-da_jI1lgEqtnzSIKcwuBIrk-6YM0Y

免責聲明:作為區塊鏈資訊平臺,本站所發佈文章僅代表作者及嘉賓個人觀點,與 Web3Caff 立場無關。 文章內的資訊僅供參考,均不構成任何投資建議及要約,並請您遵守所在國家或地區的相關法律法規。